https://arxiv.org/abs/2310.08491

Prometheus: Inducing Fine-grained Evaluation Capability in Language Models

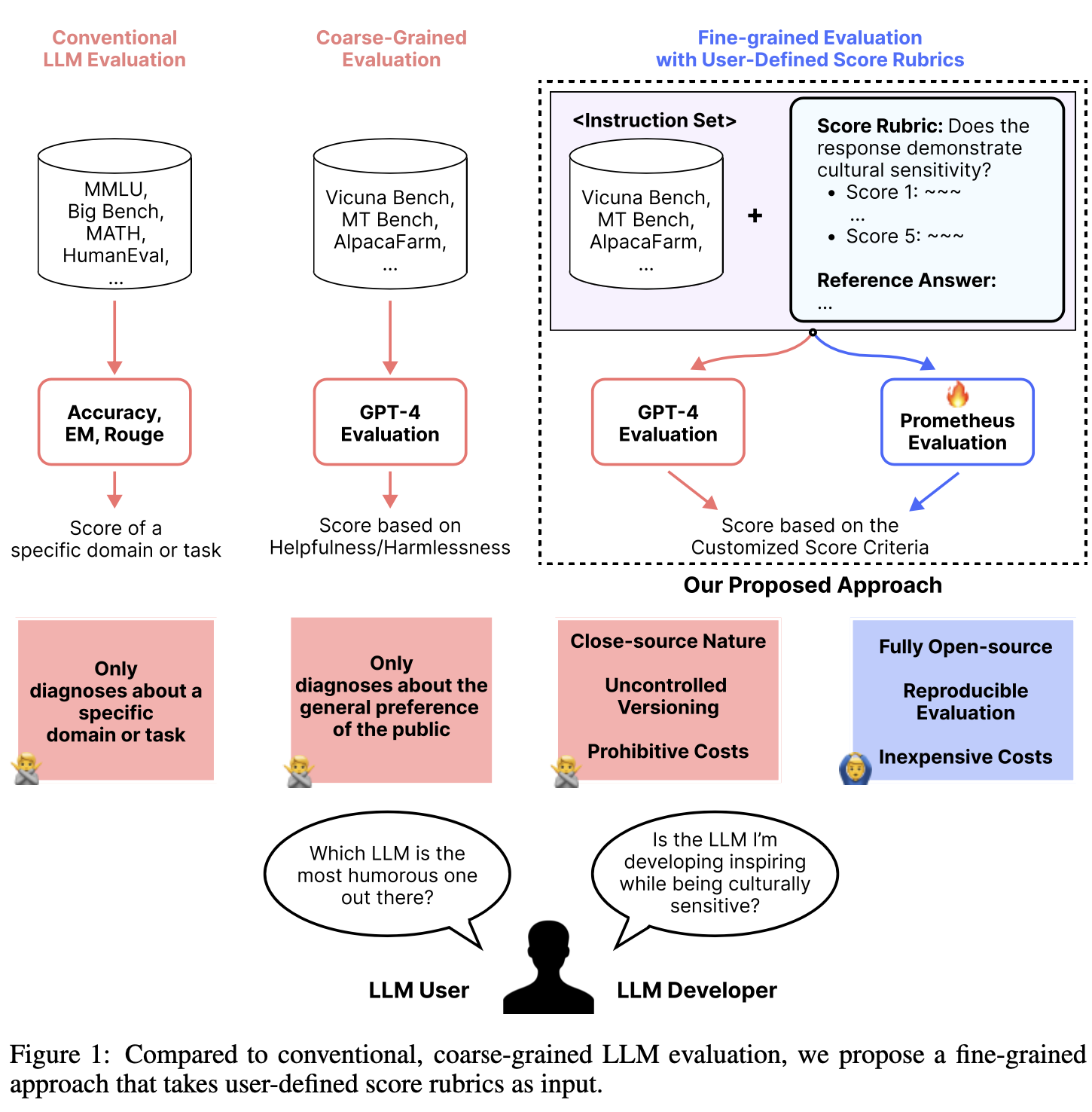

Recently, using a powerful proprietary Large Language Model (LLM) (e.g., GPT-4) as an evaluator for long-form responses has become the de facto standard. However, for practitioners with large-scale evaluation tasks and custom criteria in consideration (e.g

arxiv.org

논문이 작성되게 된 배경

논문 작성 배경은 주로 최근 대형 언어 모델(LLM)들이 인간의 평가를 대체하기 위해 사용되고 있지만, 이러한 모델들이 폐쇄적이고 버전 관리가 어려우며 비용이 많이 든다는 문제점에서 비롯되었습니다. 특히, 대규모 평가 작업이나 맞춤형 평가 기준을 적용하려는 실무자들에게는 이러한 LLM의 신뢰성이 떨어집니다.

따라서 이 논문은 GPT-4와 같은 폐쇄된 상업적 모델이 아닌, 오픈소스 기반의 LLM을 통해 맞춤형 평가 기준을 적용할 수 있는 PROMETHEUS라는 모델을 제안하고 있습니다. 이 모델은 다양한 평가 기준을 수용할 수 있도록 설계되었으며, 인간 평가자와 비슷한 수준의 평가 능력을 갖추고 있습니다.

PROMETHEUS는 주어진 참고 자료(참고 답변, 평가 기준표)를 바탕으로 GPT-4와 유사한 평가 능력을 발휘할 수 있는 오픈소스 LLM으로 개발되었으며, 이를 통해 연구자들이 보다 투명하고 비용 효율적인 방식으로 텍스트 생성 모델을 평가할 수 있게 됩니다.

THE FEEDBACK COLLECTION DATASET

이전 연구에서는 피드백을 통해 LMs를 평가자로서의 기능을 개선하기 위한 fine-tuning이 효과적임을 입증했지만, 이전 연구에서 사용된 데이터셋은 LMs를 세밀한 평가자로서 기능하게 개선하는 데 직접적으로 적용되지는 않습니다. 따라서 오픈소스 평가자 LLM을 fine-tuning하기 위한 유일한 목적으로 새로운 데이터셋인 FEEDBACK COLLECTION을 도입합니다. 데이터셋 구축 시 주요 고려사항은 다음 네 가지입니다:

- 가능한 많은 reference materials(예: reference answer 및 scoring rubric)를 포함할 것

- 각 점수(1~5)에 대한 reference answer의 길이를 균일하게 유지하여 불필요한 길이 편향을 방지할 것

- 불필요한 결정 편향을 방지하기 위해 균일한 점수 분포를 유지할 것

- 사용자가 LLM과 상호작용하는 현실적인 상황에 맞게 우리의 instructions 및 responses의 범위를 제한할 것.

이를 고려하여, FEEDBACK COLLECTION의 각 인스턴스는 입력을 위한 네 가지 구성 요소(Instruction, Response to Evaluate, Customized Score Rubric, Reference Answer)와 출력을 위한 두 가지 구성 요소(Feedback, Score)로 구성됩니다.

입력을 위한 네 가지 구성 요소

- Instruction: 사용자가 임의의 LLM에 제시할 프롬프트.

- Response to Evaluate: 평가자 LLM이 평가해야 할 Instruction에 대한 응답.

- Customized Score Rubric: 사용자가 결정한 새로운 기준의 명세. 평가자는 평가 중에 이 측면에 집중해야 합니다. 이 rubric은 (1) 기준 설명과 (2) 각 점수(1~5)의 결정 설명으로 구성됩니다.

- Reference Answer: 점수 5를 받을 수 있는 참고 답변. 평가자 LLM이 Instruction을 직접 해결하는 대신, Reference Answer와 Response 간의 상호 정보를 활용하여 점수를 결정할 수 있도록 합니다.

출력을 위한 두 가지 구성 요소

- Feedback: 제공된 응답이 특정 점수를 받게 되는 이유에 대한 논리적 설명. 이는 Chain-of-Thoughts (CoT)와 유사하며, 평가 과정을 해석 가능하게 만듭니다.

- Score: 제공된 응답에 대한 1에서 5 사이의 정수 점수.

각 인스턴스는 가능한 많은 reference material을 포함하기 위해 Instruction에 맞춰 scoring rubric과 reference answer를 동반합니다. 또한, 평가자 LLM을 훈련하는 동안 불필요한 결정 편향을 방지하기 위해 각 점수 범위(1~5)에 대해 20K 개의 동일한 수의 인스턴스를 포함합니다.

DATASET CONSTRUCTION PROCESS

GPT-4를 활용하여 대규모 FEEDBACK COLLECTION 데이터셋을 구축합니다. 구체적으로, 이 수집 과정은 다음 네 가지 단계로 이루어집니다:

- 50개의 초기 seed rubric을 구성

- GPT-4를 통해 1,000개의 새로운 score rubric으로 확장

- 현실적인 instruction의 증강

- 훈련 인스턴스의 나머지 구성 요소(즉, reference answers, feedback, score를 포함한 responses)의 증강

Step 1: Seed Rubric의 생성

scoring rubric의 기본적인 seed 데이터셋을 생성하는 것으로 시작합니다. 저자는 LLM의 출력을 평가하는 데 중요한 세부적이고 정교한 scoring rubric을 구성합니다. 이로 인해 50개의 초기 seed rubric이 만들어집니다.

Step 2: Seed Rubric의 GPT-4를 통한 확장

GPT-4와 초기 seed rubric을 사용하여 score rubric을 초기 50개에서 더 강력하고 다양한 1,000개의 score rubric으로 확장합니다. 구체적으로, 초기 seed에서 임의로 4개의 score rubric을 샘플링하여 이를 in-context learning (ICL)을 위한 시연으로 사용하고, GPT-4에게 새로운 novel score rubric을 브레인스토밍하도록 프롬프트를 제공합니다. 또한, PROMETHEUS가 다른 단어를 사용하는 유사한 score rubric으로 일반화할 수 있도록 GPT-4에게 새롭게 생성된 rubric을 패러프레이징하도록 요청합니다. 브레인스토밍 → 패러프레이징 과정을 10회 반복합니다.

Prompt for Paraphrasing as a New Score Rubric

We are brainstorming criteria with which to grade a language model on its responses in diverse situations.

A ‘criteria‘ is some useful, real-world objective, and associated rubric for scores 1-5, that tests a capability.

Here you will see 4 examples of ‘criteria‘, and their scoring rubrics, formatted as JSON.

Criteria 1:

{JSON LIST 1}

Criteria 2:

{JSON LIST 2}

Criteria 3:

{JSON LIST 3}

Criteria 4:

{JSON LIST 4}

Please brainstorm a new criteria and scoring rubrics.

Be creative and create new but useful criteria that people in different settings or industries might find practical.

Please format the output as same as the above examples with no extra or surrounding text. Write [END] after you are done.

New Criteria:

Prompt for Paraphrasing as a New Score Rubric

Please paraphrase the sentences inside the dictionary below.

Each paraphrase should not change the meaning or substance of the original sentence, be naturally written, but sufficiently diverse from one another.

Diversity can come from differences in diction, phrasing, sentence structure, formality, detail, and/or other stylistic changes.

The dictionary:

{CRITERIA}

Respond with only dictionary (same format as the given dictionary) with no extra or surrounding text.

Write [END] after you are done.

Dictionary with Paraphrased Sentences:

Step 3: Score Rubric과 관련된 새로운 Instruction 제작

1,000개의 rubric으로 구성된 포괄적인 데이터셋을 갖춘 후, 다음 도전 과제는 관련된 훈련 인스턴스를 제작하는 것입니다. 예를 들어, "상사에게 보낼 만큼 충분히 형식적인가요?"라는 score rubric은 수학 문제와 관련이 없습니다. score rubric과 밀접하게 관련된 instruction 세트가 필요하다는 점을 고려하여, GPT-4에게 주어진 score rubric과 매우 관련성이 높은 20K개의 고유한 instruction을 생성하도록 요청합니다.

Prompt for Generating an Instruction and Reference Answer

Your job is to generate a new novel problem and a response that is related to the given score rubric.

The score rubric:

{CRITERIA}

* Problem

- The problem should inherently be related to the score criteria and score rubric given above. Specifically, the score criteria should be the core attributes required to solve the problem.

- The problem itself should not be too generic or easy to solve.

- If the score rubric is related to logical abilities, generate problems that require math or coding abilities.

- Try to make the person who might solve the problem not notice the existence of the score rubric by not explicitly mentioning it, and also provide additional inputs and options if needed.

- Assume a situation where a user is interacting with an AI model. The user would try to ask in a first-person point of view, but not using terms like ”I”, ”A User” or ”You” in the first sentence.

- Do not give a role to the AI, assume that the user is asking a question from his point of view.

- Do not include any phrase related to AI model in the problem.

* Response

- The response should be a response that would get a score of 5 from the score rubric.

- The response should be as detailed as possible unless the score rubric is related to conciseness or brevity. It should consist of multiple paragraphs, a list of items, or a step-by-step reasoning process.

- The response should look like how a well-prompted GPT-4 would normally answer your problem.

* Format

- DO NOT WRITE ANY GREETING MESSAGES, just write the problem and response only.

- In front of the problem, append the phrase ”Problem:” and in front of the response, append the phrase ”Response:”.

- Write in the order of ”Problem” - ”Response”, where the two items are separated by the phrase ”[NEXT]”.

- Write [END] after you are done.

Data Generation:

Step 4: 훈련 인스턴스 제작

마지막으로, GPT-4에게 프롬프트를 제공하여 각 구성 요소를 순차적으로 생성함으로써 평가할 response와 해당하는 feedback을 생성합니다. 이 과정에서 각 score rubric에 대해 20개의 instruction과, 각 instruction에 대해 5개의 response 및 feedback을 생성합니다. 평가자 LLM을 fine-tuning할 때 결정 편향의 영향을 제거하기 위해 각 점수에 대해 20K 개의 동일한 수의 response를 생성합니다. 점수 5를 받는 response의 경우, 두 개의 고유한 response를 생성하여 그 중 하나를 입력(reference answer)으로 사용할 수 있도록 합니다.

Prompt for Generating Responses and Feedback

Your job is to generate a response that would get a score of {SCORE} and corresponding feedback based on the given score rubric. For reference, a reference response that would get a score of 5 is also given.

Instruction:

{INSTRUCTION}

The score rubric:

{CRITERIA}

Reference response (Score 5):

{REFERENCE}

* Response

- The quality of the score {SCORE} response should be determined based on the score rubric, not by its length.

- The score {SCORE} response should have the same length as the reference response, composed of {SENT NUM} sentences.

- Do not explicitly state the keywords of the score rubric inside the response.

* Feedback

- The score {SCORE} feedback should each be an explanation of why the response would get a score of {SCORE}. It should be written based on the generated response and score rubric.

- The score {SCORE} feedback shouldn’t just copy and paste the score rubric, but it should also give very detailed feedback on the content of the corresponding response.

- The score {SCORE} feedback should include the phrase ”So the overall score is {SCORE}” in the last sentence.

* Format

- DO NOT WRITE ANY GREETING MESSAGES, just write the problem and response only.

- In front of the response, append the phrase ”Response:” and in front of the feedback, append the phrase ”Feedback:”.

- Write in the order of ”Response” - ”Feedback”, where the two items are separated by the phrase ”[NEXT]”.

- Write [END] after you are done.

Data Generation:

FINE-TUNING AN EVALUATOR LM

FEEDBACK COLLECTION 데이터셋을 사용하여 Llama-2-Chat(7B 및 13B)을 fine-tuning하고, 세밀한 평가 기능을 유도하는 PROMETHEUS를 얻습니다. Chain-of-Thought Fine-tuning과 유사하게, 피드백을 순차적으로 생성한 다음 점수를 생성하도록 fine-tuning을 진행합니다. 추론 과정에서 퇴화를 방지하기 위해 피드백과 점수 사이에 '[RESULT]'와 같은 구문을 포함하는 것이 중요함을 강조합니다.

Prompt for Prometheus

###Task Description:

An instruction (might include an Input inside it), a response to evaluate, a reference answer that gets a score of 5, and a score rubric representing an evaluation criterion is given.

1. Write a detailed feedback that assesses the quality of the response strictly based on the given score rubric, not evaluating in general.

2. After writing a feedback, write a score that is an integer between 1 and 5. You should refer to the score rubric.

3. The output format should look as follows: Feedback: (write a feedback for criteria) [RESULT] (an integer number between 1 and 5) ̈

4. Please do not generate any other opening, closing, and explanations.

###The instruction to evaluate:

{instruction}

###Response to evaluate:

{response}

###Reference Answer (Score 5):

{reference answer}

###Score Rubrics:

[{ criteria description }]

Score 1: {score1 description}

Score 2: {score2 description}

Score 3: {score3 description}

Score 4: {score4 description}

Score 5: {score5 description}

###Feedback:

EXPERIMENTAL RESULTS

CAN PROMETHEUS CLOSELY SIMULATE HUMAN EVALUATION?

Human Scoring와의 상관관계

FEEDBACK BENCH(Unseen Score Rubric subset), MT Bench(Zheng et al., 2023), Vicuna Bench(Chiang et al., 2023)라는 세 가지 평가 데이터셋에서 각각 45개의 고유한 맞춤형 점수 기준표를 사용하여 human annotators와 모델 간의 상관관계를 비교했습니다. PROMETHEUS가 세 가지 평가 데이터셋 모두에서 GPT-4와 동등한 수준임을 보여줍니다. PROMETHEUS는 Pearson 상관계수 0.897을 얻었고, GPT-4는 0.882, GPT-3.5-Turbo는 0.392를 얻었습니다.

Human Evaluation과 피드백의 Pairwise Comparison

PROMETHEUS가 점수 결정 외에도 유용하고 의미 있는 피드백을 생성하는지를 확인하기 위해, human annotators에게 더 나은 피드백을 선택하도록 요청했습니다. PROMETHEUS가 GPT-4보다 58.62%의 비율로, GPT-3.5-Turbo보다 79.57%의 비율로 선호되었음을 보여줍니다. 이는 PROMETHEUS의 피드백이 또한 의미 있고 유용하다는 것을 나타냅니다.

PROMETHEUS 피드백이 선호된 이유에 대한 분석

피드백 품질의 Pairwise Comparison 외에도, 인간 평가자에게 피드백을 선호하는 이유를 6가지 포괄적인 옵션 중 최소 하나를 선택하여 분석하도록 했습니다. GPT-4는 주로 일반적이거나 추상적인 피드백을 제공했기 때문에 선택되지 않은 반면, PROMETHEUS는 주로 주어진 응답에 대해 지나치게 비판적이어서 선택되지 않았습니다. 이 결과를 바탕으로 GPT-4가 보다 중립적이고 추상적인 경향을 보이는 반면, PROMETHEUS는 주어진 응답이 좋은지 여부에 대한 의견을 명확하게 표현하는 경향이 있음을 알 수 있습니다. 이는 PROMETHEUS를 오직 세밀한 평가만 수행하도록 직접적으로 fine-tuning한 결과로, 본질적으로 이를 생성자가 아닌 평가자로 변환시킨 것이라고 추측합니다.

CAN PROMETHEUS CLOSELY SIMULATE GPT-4 EVALUATION?

GPT-4 점수와의 상관관계

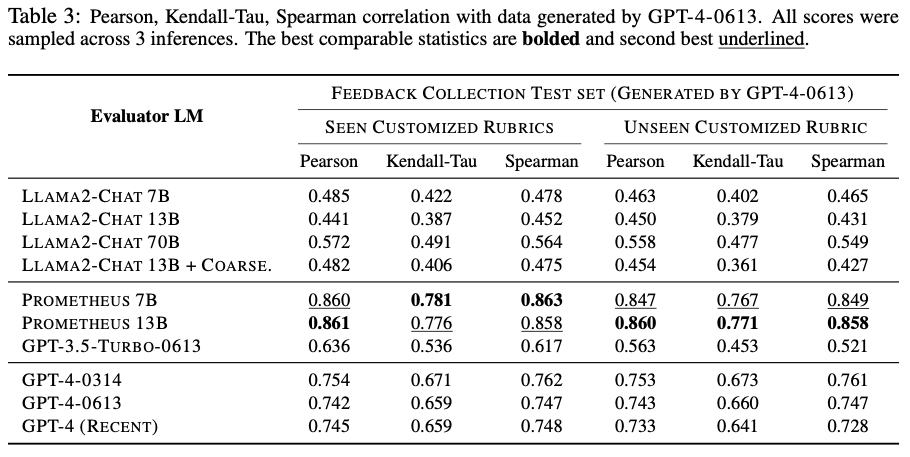

FEEDBACK BENCH(Seen 및 Unseen Score Rubric Subset), Vicuna Bench, MT Bench, Flask Eval에서 총 2360개의 인스턴스에 대해 1222개의 score rubric을 사용하여 GPT-4 평가와 기준 모델 간의 상관관계를 절대 평가 방식으로 비교했습니다. FEEDBACK BENCH의 경우, GPT-4-0613에서 생성된 점수와의 상관관계를 측정했고, 나머지 3개의 데이터셋에서는 GPT-4-0613으로 추론한 점수와의 상관관계를 측정했습니다.

Table 3에서 LLAMA-2-CHAT 13B의 성능은 7B 모델보다 감소했으며, 70B 크기로 확장되었을 때 약간의 성능 향상을 보였지만, 단순히 모델 크기를 늘리는 것이 LLM의 평가 능력을 반드시 향상시키는 것은 아님을 보여줍니다. 반면, PROMETHEUS 13B는 Pearson 상관관계에서 본 모델인 LLAMA2-CHAT 13B보다 Seen rubric 세트에서 +0.420, Unseen rubric 세트에서 +0.397의 향상을 보였습니다. 또한, PROMETHEUS는 LLAMA2-CHAT 70B, GPT-3.5-TURBO-0613, 그리고 다양한 버전의 GPT-4를 능가하는 성과를 보였습니다. PROMETHEUS의 높은 성능은 테스트 세트 내의 instructions 및 responses가 우리가 사용한 훈련 세트와 유사한 분포를 공유할 수 있기 때문이라고 추정됩니다(LLM과 상호작용하는 시나리오를 시뮬레이션하는 경우), 비록 score rubric이 보이지 않는 경우에도 말입니다. 또한, coarse-grained score rubric에서 도출된 피드백으로 훈련한 LLAMA2-CHAT 13B + COARSE의 성능 향상은 미미했으며, 이는 다양한 score rubric에서 훈련하는 것이 맞춤형 rubric을 처리하는 데 중요함을 나타냅니다.

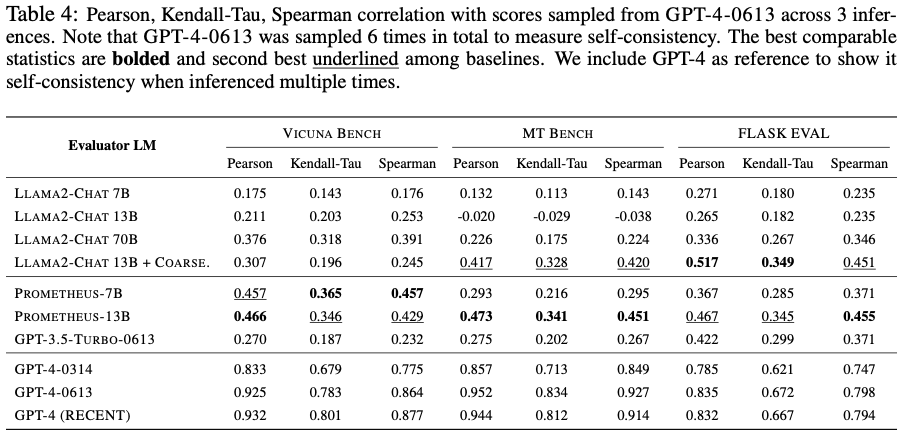

Table 4에서는 LLAMA2-CHAT의 다양한 크기 간의 경향이 유사함을 보여줍니다. 단순히 크기를 늘리는 것만으로는 LLM의 평가 능력이 크게 향상되지 않습니다. 이러한 벤치마크에서 PROMETHEUS는 Vicuna Bench, MT Bench, Flask Eval 데이터셋에서 각각 +0.255, +0.493, +0.202의 Pearson 상관관계 향상을 보여주며 본 모델인 LLAMA2-CHAT-13B를 능가했습니다. PROMETHEUS는 LLAMA2-CHAT 70B와 GPT-3.5-TURBO-0613을 능가하지만, GPT-4보다는 뒤처집니다. 이는 FEEDBACK COLLECTION의 instructions과 평가 데이터셋의 특성이 다르기 때문일 수 있습니다. FEEDBACK COLLECTION의 instructions은 상대적으로 길고 상세한 반면(예: "나는 도시 계획자입니다... 인구 증가로 인한 교통 혼잡과 대기 문제를 해결하기 위한 새로운 진보적인 해결책을 찾고 있습니다."), 평가에 사용된 데이터셋은 짧은 특징을 가지고 있습니다(예: "양자역학에 대해 설명할 수 있나요?")

한편, Flask Eval 데이터셋에서는 Flask Eval 데이터셋으로 특화된 훈련을 받은 LLAMA2-CHAT 13B + COARSE가 PROMETHEUS를 능가했다는 점이 중요합니다. 이는 특정 작업에 맞는 평가자 LLM을 얻기 위해서는 평가 데이터셋에서 직접 훈련하는 것이 최선의 방법일 수 있음을 나타냅니다.

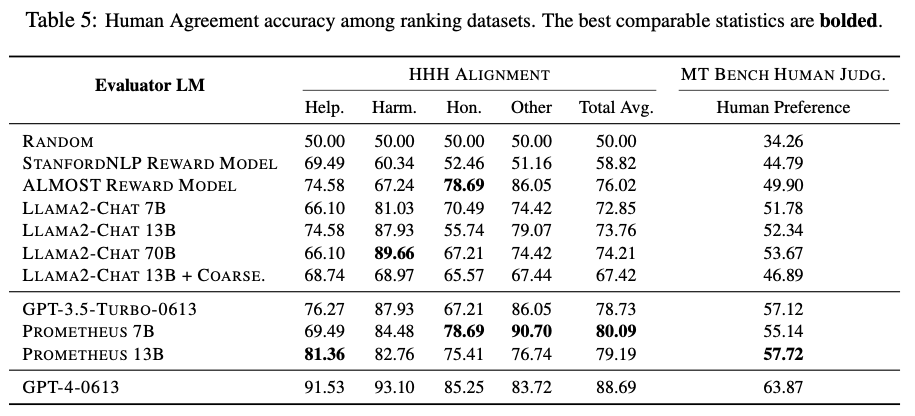

CAN PROMETHEUS FUNCTION AS A REWARD MODEL?

우리는 HHH Alignment와 MT Bench Human Judgment라는 두 개의 인간 선호도 데이터셋에서 랭킹 평가 방식을 사용하는 실험을 진행했습니다.

Table 5의 결과에 따르면, LLAMA-2-CHAT 모델이 놀라운 성능을 발휘했는데, 이는 Reinforcement Learning from Human Feedback (RLHF)으로 훈련된 기본 모델을 사용한 효과일 수 있다고 추정됩니다. Coarse-grained score rubrics에서 도출된 피드백으로 훈련한 경우(LLAMA2-CHAT 13B + COARSE)는 성능이 오히려 저하되었습니다. 반면, PROMETHEUS 13B는 HHH Alignment와 MT Bench Human Judgment 데이터셋에서 각각 본 모델인 LLAMA2-CHAT-13B보다 +5.43% 및 +5.38%의 성능 향상을 보였습니다. 이러한 결과는 절대 평가 방식으로 훈련하는 것이 랭킹 평가 방식에서도 성능을 향상시킬 수 있음을 시사하며, 랭킹 평가 인스턴스에 대해 직접적인 훈련 없이도 가능함을 보여줍니다. 또한, 생성형 LLM(PROMETHEUS)을 RLHF의 보상 모델로 사용할 가능성을 나타냅니다.

DISCUSSIONS AND ANALYSIS

WHY IS IT IMPORTANT TO INCLUDE REFERENCE MATERIALS?

참조 자료 없이 주어진 응답을 평가하는 것은 매우 어려운 작업입니다(즉, 지시문과 응답만 주어졌을 때 점수를 결정하도록 요청하는 경우). 이는 평가 LLM이 (1) 지시문에 맞춰 중요한 측면이 무엇인지 알아야 하고, (2) 지시문의 답변이 무엇일지 내부적으로 추정해야 하며, (3) 이전 두 단계에서 도출된 정보를 바탕으로 응답의 품질을 평가해야 하기 때문입니다. 우리의 직관은 참조 자료 내의 각 구성 요소를 포함함으로써, 평가자 LLM이 중요한 측면을 결정하거나 지시문을 해결하는 대신 응답의 품질을 평가하는 데만 집중할 수 있게 한다는 것입니다. 구체적으로, 각 구성 요소의 역할은 다음과 같습니다:

- Score Rubric: 주어진 지시문을 다루는 데 필수적인 중요한 측면에 대한 정보를 제공합니다. Score Rubric이 없으면, 평가자 LLM은 지시문에서 고려해야 할 세부 사항을 본질적으로 파악해야 합니다.

- Reference Answer: 참조 답변을 추정하고 동시에 평가하는 과정을 두 단계로 분리합니다. 참조 답변이 추가 입력으로 제공되면, 평가자 LLM은 주어진 응답을 평가하는 데만 집중할 수 있습니다. 이는 평가자 LLM이 문제를 해결할 수 없다면, 다양한 응답을 효과적으로 평가할 수 없다는 자연스러운 가정을 피할 수 있게 해줍니다.

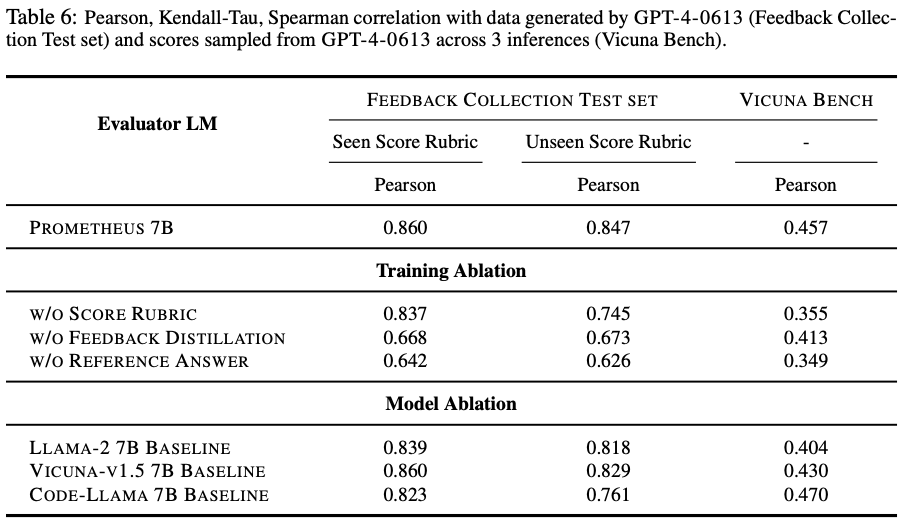

Table 6에 나타난 바와 같이, 우리는 각 참조 자료를 제외한 ablation 실험을 수행하고, 피드백을 생성하지 않고 score rubric만으로 훈련하는 실험도 진행했습니다. 또한, Llama-2-Chat 대신 Llama-2, Vicuna, Code-Llama 등 다른 모델 변형을 사용한 효과도 분석했습니다.

훈련 Ablation: 결과는 각 구성 요소가 PROMETHEUS의 우수한 평가 성능에 독립적으로 기여한다는 것을 나타냅니다. 특히, 참조 답변을 제외하는 것이 성능 저하에 가장 큰 영향을 미치며, 이는 참조 답변을 포함하는 것이 평가자 LLM이 지시문을 내부적으로 해결할 필요를 없애고 응답 평가에만 집중할 수 있게 한다는 우리의 주장을 뒷받침합니다. 또한, FEEDBACK BENCH에서 score rubric을 제외해도 성능이 크게 저하되지 않지만, Vicuna Bench에서 평가할 때는 성능이 크게 떨어집니다. 우리의 가설처럼, 다른 데이터셋에서 일반화하기 위해서는 무엇을 평가해야 하는지를 제공하는 역할이 상대적으로 중요하다고 추정합니다.

모델 Ablation: LLAMA2-CHAT을 사용한 효과를 테스트하기 위해, 감독 하에 fine-tuning 및 RLHF가 모두 적용된 모델을 시작점으로 사용하여 실험했습니다. 결과는 다른 모델 선택이 성능에 크게 해를 끼치지 않지만, supervised fine-tuning과 RLHF가 모두 적용된 모델이 최고의 성능을 보인다는 것을 보여줍니다. 이는 지시문을 따르는 추가적인 훈련 덕분일 가능성이 있습니다. 그러나 Code-Llama를 사용하는 것이 코드 도메인에서 평가할 때 일부 이점이 있음을 발견했습니다.

NARROWING PERFORMANCE GAP TO GPT-4 EVALUATION

PROMETHEUS가 인간 평가에 기반한 점수와 피드백의 질, 그리고 FEEDBACK BENCH에서의 상관관계 측면에서 일관되게 GPT-4를 능가하는 결과는 주목할 만합니다. 우리는 이러한 결과가 단순한 우연이 아니며, 다음과 같은 이유를 제시합니다:

- FEEDBACK BENCH 결과: 우리의 모델은 이 데이터에 대해 직접 fine-tuning되었기 때문에, 잘 훈련된 경우 유사한 분포의 테스트 세트에서 GPT-4를 능가하는 것은 자연스러운 일입니다. 또한, GPT-4의 경우 지시문에 대한 추론 결과와 새로운 인스턴스를 증강하여 비교했기 때문에 자체 일관성이 낮아질 수 있습니다.

- 인간 평가에서의 점수 상관관계: 우리의 모델은 유사하거나 약간 더 높은 경향을 보입니다. 첫째, 우리의 인간 평가 설정에서 모든 코드나 수학 관련 질문을 제외했는데, 이는 아직 GPT-4를 능가하기 쉽지 않은 영역입니다. 둘째, 항상 인간 오류의 여지를 고려해야 합니다. 그럼에도 불구하고, 우리는 적절한 참조 자료가 수반될 때 오픈소스 평가자 LLM이 GPT-4 평가에 근접할 수 있음을 주장한 최초의 연구임을 강조합니다.

- Figure 6에서 나타난 바와 같이, PROMETHEUS는 GPT-4에 비해 비판적인 경향을 보입니다: 이는 PROMETHEUS가 평가에 특화되어 있기 때문에 응답을 평가할 때 개선을 추구하는 특성을 가지게 되었기 때문이라고 추정됩니다.

A PRACTITIONER’S GUIDE FOR DIRECTLY USING PROMETHEUS EVALUATION

평가 데이터셋 준비

이전 섹션에서 설명한 것처럼, PROMETHEUS는 FEEDBACK BENCH(훈련된 데이터셋과 유사한 분포를 가진 데이터셋)뿐만 아니라 Vicuna Bench, MT Bench, Flask Eval과 같은 다른 널리 사용되는 평가 데이터셋에서도 좋은 평가 LLM으로 기능합니다. Figure 1에 나타난 것처럼, 사용자는 평가하려는 대상 LLM에 대해 평가할 지시문 데이터셋을 준비해야 합니다. 이는 널리 사용되는 지시문 데이터셋일 수도 있고, 사용자가 가지고 있는 맞춤형 평가 데이터셋일 수도 있습니다.

평가할 Score Rubric 결정

다음 단계는 사용자가 대상 LLM을 테스트하고자 하는 score rubric을 선택하는 것입니다. 이는 helpfulness/harmfulness와 같은 일반적인 메트릭에 국한될 수 있지만, PROMETHEUS는 "Child-Safety", "Creativity", 또는 "응답이 상사에게 보낼 만큼 충분히 형식적인가?"와 같은 세밀한 score rubric도 지원합니다.

참조 답변 준비

참조 없이 평가하는 것도 가능하지만, Table 6에서 보듯이 참조 답변이 제공될 때 PROMETHEUS가 더 우수한 성능을 보입니다. 따라서 사용자는 평가하고자 하는 지시문과 score rubric에 따라 가장 적합하다고 생각되는 참조 답변을 준비해야 합니다. 이를 준비하는 데 추가 비용이 들 수 있지만, 전체 평가 과정의 정밀도나 정확성을 향상시키기 위한 명확한 트레이드오프가 있으므로 중요한 요소입니다.

대상 LLM을 사용한 응답 생성

마지막 단계는 사용자가 평가하고자 하는 대상 LLM에서 얻은 응답을 준비하는 것입니다. 평가할 지시문과 응답과 함께 참조 자료(score rubric, 참조 답변)를 제공함으로써 PROMETHEUS는 피드백과 점수를 생성합니다. 사용자는 이 점수를 사용하여 대상 LLM이 맞춤형 기준에 따라 얼마나 잘 수행되는지 판단할 수 있으며, 피드백을 참조하여 대상 LLM의 특성과 동작을 분석하고 확인할 수 있습니다. 예를 들어, PROMETHEUS는 새로운 LLM을 훈련할 때 GPT-4 평가의 좋은 대안으로 사용할 수 있습니다. 구체적으로, 이 분야는 새로운 LLM을 개발하는 동안 instruction-tuning 또는 RLHF의 세부 사항을 결정하는 정형화된 절차를 아직 마련하지 않았습니다. 여기에는 얼마나 많은 훈련 인스턴스를 사용할지, 훈련 하이퍼파라미터를 체계적으로 결정하는 방법, 여러 버전에 걸쳐 LLM의 동작을 정량적으로 분석하는 방법이 포함됩니다. 무엇보다도, 사용자는 자신의 LLM이 생성한 출력을 OpenAI API에 보내고 싶지 않을 수 있습니다. 이러한 점에서 PROMETHEUS는 전체 평가 프로세스에 대한 통제력을 제공하며, 맞춤형 score rubric도 지원하는 매력적인 솔루션을 제공합니다.

A PRACTITIONER’S GUIDE FOR TRAINING A NEW EVALUATION MODEL

사용자들은 다양한 사용 사례에 맞춰 PROMETHEUS처럼 맞춤형 평가자 LLM을 훈련하고자 할 수 있습니다. Table 4에서 보듯이, Flask 데이터셋에서 직접 훈련한 경우(LLAMA2-CHAT 13B + COARSE)는 FEEDBACK COLLECTION에서 훈련한 PROMETHEUS보다 Flask Eval 데이터셋에서 GPT-4와의 상관관계가 더 높게 나타났습니다. 이는 목표 피드백 데이터셋에서 직접 훈련하는 것이 해당 작업에서 최상의 성능을 발휘함을 시사합니다. 그러나 이는 새로운 피드백 데이터셋을 준비하는 과정(Section 3.1에 설명됨)을 거쳐야 하며, 이는 목표 작업에서 강력한 평가자 LLM을 얻는 것과 새로운 피드백 데이터셋을 준비하는 초기 비용 간의 트레이드오프가 있음을 의미합니다. 이 섹션에서는 사용자들이 피드백 데이터셋을 사용하여 평가자 LLM을 훈련할 수 있는 가이드라인을 제공합니다.

훈련할 피드백 데이터셋 준비

Section 3에서 설명한 대로, 새로운 피드백 데이터셋을 준비할 때 중요한 고려 사항은 다음과 같습니다: (1) 가능한 한 많은 참조 자료를 포함할 것, (2) 각 점수(1~5)에 대한 참조 답변의 길이를 균일하게 유지하여 불필요한 길이 편향을 방지할 것, (3) 불필요한 결정 편향을 방지하기 위해 균일한 점수 분포를 유지할 것. 우리는 제한된 컨텍스트 길이로 인해 "Score 1 Reference Answer" 또는 "Background Knowledge"와 같은 다른 가능한 참조 자료를 포함하는 효과를 탐구하지 않았지만, 이는 향후 연구에서 다룰 수 있는 부분입니다. 기본 직관은 더 많은 참조 자료를 제공함으로써 평가자 LLM이 지시문을 해결하는 대신 평가에만 집중할 수 있게 한다는 것입니다.

평가자 LLM을 훈련할 기본 모델 선택

Figure 19에서 보듯이, CODE-LLAMA로 훈련할 경우 코드 도메인에서 응답을 평가할 때 더 상세한 피드백과 합리적인 점수 결정을 제공함을 발견했습니다(Vicuna Bench 데이터셋에 포함된 7개의 인스턴스에서). 이는 평가자 LLM을 설계할 때 평가하려는 도메인에 따라 다른 기본 모델을 선택하는 것이 중요할 수 있음을 나타냅니다.

'AI > 기술,논문 리뷰' 카테고리의 다른 글

| QwQ-32B-Preview; Qwen 시리즈의 OpenAI o1의 대항마? (3) | 2024.11.29 |

|---|---|

| LogicKor: 한국어 언어모델 다분야 사고력 벤치마크 (1) | 2024.08.30 |

| G-EVAL: NLG Evaluation using GPT-4 with Better Human Alignment (1) | 2024.08.30 |

| Judging LLM-as-a-Judge with MT-Bench and Chatbot Arena (0) | 2024.08.07 |

| Efficient LLM Inference with KCache (1) | 2024.05.08 |