인공지능(AI) 기술의 발전과 함께, AI 시스템이 외부 데이터와 효과적으로 연동되는 것이 점점 더 중요한 이슈로 떠오르고 있습니다. 기존에는 AI 모델이 내부적으로 훈련된 데이터만을 기반으로 작동하는 경우가 많았지만, 실시간 정보 활용과 동적 컨텍스트 유지가 필수적인 환경에서는 이러한 방식이 한계를 보였습니다. 이에 따라, AI 시스템이 외부 데이터와 원활하게 통신하고 정보를 활용할 수 있는 새로운 프로토콜이 필요해졌습니다.

2024년 11월, Anthropic이 Model Context Protocol(MCP)을 오픈 소스로 공개하면서, AI 생태계에서는 새로운 변화의 바람이 불기 시작했습니다. MCP는 AI 모델이 다양한 데이터 소스와 연결되어 실시간으로 정보를 주고받을 수 있도록 설계된 프로토콜로, 이를 활용하면 AI가 더욱 정확하고 풍부한 답변을 제공할 수 있습니다. 이러한 혁신적인 접근 방식은 기업과 개발자들에게 큰 관심을 끌고 있으며, AI의 활용 범위를 넓히는 데 중요한 역할을 하고 있습니다.

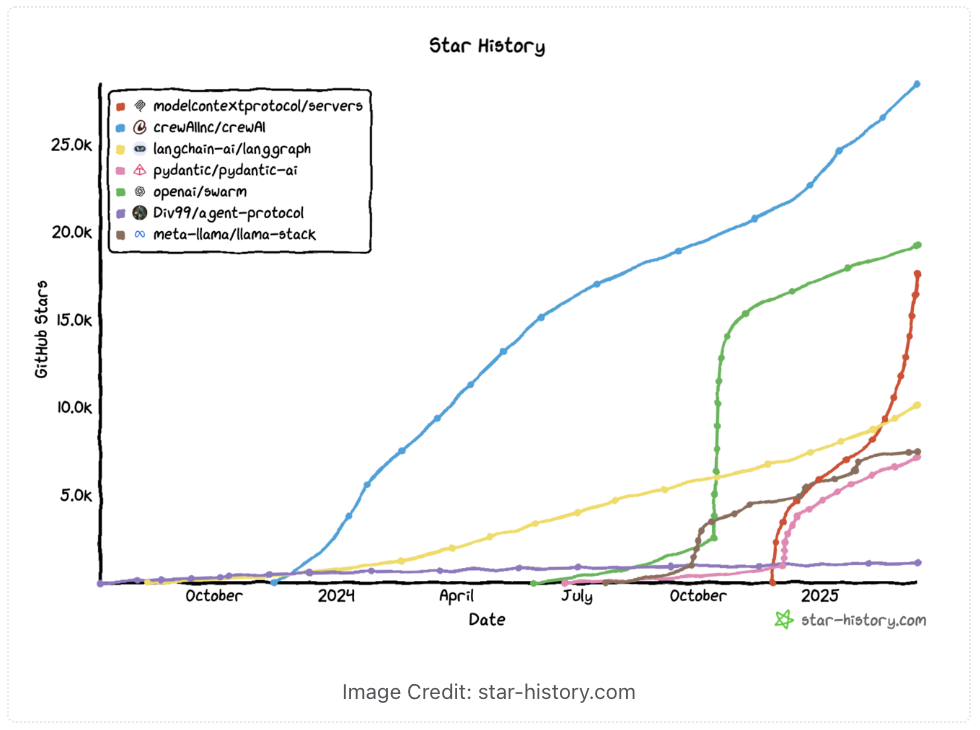

2024년 11월, Anthropic이 Model Context Protocol(MCP)을 오픈 소스로 공개하였지만 당시에는 큰 주목을 받지 못했습니다. 그러나 2025년 초부터 MCP에 대한 관심이 급증하고 있는데, 이러한 변화의 주요 요인 중 하나는 AI 에이전트와 에이전틱 워크플로우의 발전에 따라, 실제 비즈니스 시스템과 데이터를 AI 에이전트에 통합하는 필요성이 대두되었기 때문입니다. MCP는 이러한 통합 문제를 해결하는 표준으로서, 파일 시스템, 데이터베이스, API 등 기존 데이터 소스를 AI 워크플로우에 연결하는 방법을 정의하여, 생산 준비가 된 AI 에이전트를 구축하는 데 필수적인 요소로 부상하였습니다.

또한, 커뮤니티의 성장과 채택도 MCP의 인기에 기여했습니다. 몇 달 만에 MCP는 개념에서 성장하는 생태계로 발전하였으며, 주요 AI 기업과 오픈 소스 커뮤니티가 MCP를 채택하고 있습니다. 이러한 채택은 MCP를 기반으로 한 에이전틱 AI 시스템 구축을 촉진하고 있으며, 이는 MCP에 대한 관심 증가의 또 다른 요인입니다.

이러한 맥락에서, Manus AI와 같은 혁신적인 AI 에이전트의 출시는 MCP의 중요성을 더욱 부각시켰습니다. Manus AI는 사용자의 지시에 따라 웹 브라우징, 코드 작성 등 다양한 작업을 수행하는 범용 AI 에이전트로, 기존의 AI 모델인 Claude Sonnet 3.5와 Qwen을 기반으로 설계되었습니다. 이러한 AI 에이전트의 기능은 다양한 도구와의 통합을 통해 강화되며, 이 과정에서 MCP와 같은 프로토콜이 중요한 역할을 합니다. 따라서, Manus AI와 같은 AI 에이전트의 등장은 MCP에 대한 관심 증가에 직접적인 영향을 미쳤습니다.

MCP란 무엇인가

MCP는 "대규모 언어 모델이 외부 데이터와 시스템을 더 효과적으로 활용할 수 있도록 설계된 일종의 연결 프로토콜"입니다. 앤트로픽은 MCP를 USB-C 포트에 비유합니다. USB-C가 다양한 기기와 주변 장치를 표준화된 방식으로 연결하듯이, MCP는 AI 모델이 다양한 데이터 소스와 도구에 표준화된 방식으로 연결될 수 있게 해줍니다.

MCP의 주요 특징은 다음과 같습니다:

- 개방형 표준(Open Standard): MCP는 오픈소스로 공개되어 있어 누구나 자유롭게 사용하고 개선할 수 있습니다. 앤트로픽이 개발했지만 Claude와 같은 그들의 모델에만 국한되지 않고, 어떤 AI 시스템에서도 사용할 수 있습니다.

- 양방향 연결(Two-way Connection): MCP는 AI 모델과 데이터 소스 간의 양방향 통신을 지원합니다. 기존 API 호출 방식에서는 AI가 데이터를 요청하면 서버가 한 번 응답하고 끝나는 방식이었지만, MCP에서는 AI 모델과 데이터 소스가 지속적으로 연결된 상태에서 서로 정보를 주고받을 수 있습니다.

- 범용성과 표준화(Universality and Standardization): MCP는 다양한 데이터 소스와 도구를 하나의 표준 프로토콜로 연결할 수 있게 해줍니다. 개발자는 각 데이터 소스마다 별도의 커넥터를 유지할 필요 없이 단일 프로토콜을 통해 연결할 수 있습니다.

- 보안 및 신뢰성(Security and Reliability): MCP는 AI 모델과 데이터 소스 간의 안전하고 신뢰할 수 있는 연결을 제공합니다. 이를 통해 개인 정보 보호와 데이터 무결성을 유지할 수 있습니다.

MCP는 AI 모델이 단순히 텍스트를 생성하는 것을 넘어서, 필요한 정보를 실시간으로 가져오고 다른 소프트웨어나 데이터 시스템과 협업할 수 있도록 만들어 주는 기술입니다. 이를 통해 AI 모델의 성능과 실제 활용도를 높이는 것이 MCP의 핵심 목표입니다.

MCP의 핵심 구성 요소

MCP는 클라이언트-서버 아키텍처를 기반으로 하며, AI 모델과 외부 데이터 소스 간의 원활한 통신을 가능하게 하는 구조로 설계되었습니다. MCP는 다음과 같은 세 가지 핵심 구성 요소로 이루어져 있습니다:

호스트(Host)

- AI 애플리케이션의 컨테이너이자 조정자 역할을 합니다.

- 여러 클라이언트 인스턴스를 관리합니다.

- 클라이언트 연결 권한과 생명주기를 제어합니다.

- 보안 정책과 동의 요구사항을 시행합니다.

- AI/LLM 통합 및 샘플링을 조정합니다.

- 클라이언트 간 컨텍스트 집계를 관리합니다.

- ex) Claude App, IDEs, AI 도구들

MCP 클라이언트(MCP Clients)

- 호스트에 의해 생성되며 서버와의 독립적인 연결을 유지합니다.

- 서버당 하나의 상태 유지 세션을 설정합니다.

- 프로토콜 협상 및 기능 교환을 처리합니다.

- 양방향으로 프로토콜 메시지를 라우팅합니다.

- 구독 및 알림을 관리합니다.

- 서버 간 보안 경계를 유지합니다.

MCP 서버(MCP Servers)

- 특화된 컨텍스트와 기능을 제공합니다.

- MCP 기본 요소를 통해 리소스, 도구 및 프롬프트를 노출합니다.

- 독립적으로 작동하며 집중된 책임을 가집니다.

- 클라이언트 인터페이스를 통해 샘플링을 요청합니다.

- 보안 제약을 준수해야 합니다.

- 로컬 프로세스 또는 원격 서비스일 수 있습니다.

MCP의 작동 방식

MCP의 작동 방식은 다음과 같은 단계로 이루어집니다:

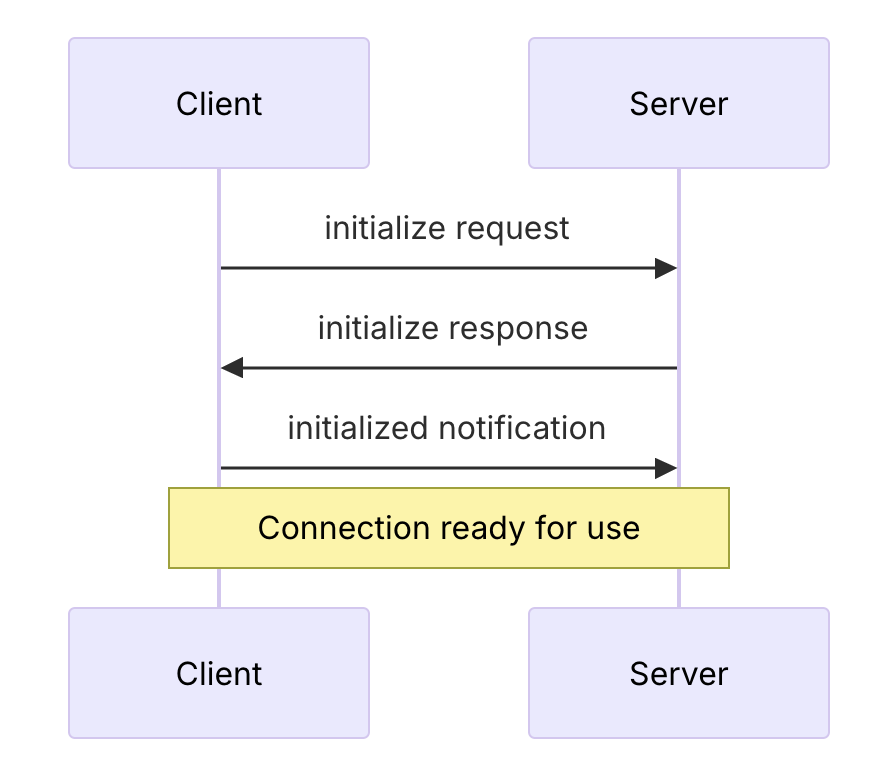

연결 설정(Connection Establishment)

- 호스트 애플리케이션(예: Claude Desktop)이 MCP 클라이언트를 생성합니다.

- 클라이언트는 MCP 서버와 연결을 설정합니다.

- 연결 설정 과정에서 프로토콜 버전, 기능, 권한 등이 협상됩니다.

컨텍스트 교환(Context Exchange)

- 서버는 클라이언트에게 데이터 소스의 컨텍스트 정보를 제공합니다.

- 클라이언트는 이 정보를 호스트 프로세스에 전달합니다.

- 호스트 프로세스는 여러 클라이언트로부터 받은 컨텍스트를 집계하여 AI 모델에 제공합니다.

도구 호출(Tool Invocation)

- AI 모델은 특정 작업을 수행하기 위해 도구 호출을 요청할 수 있습니다.

- 호스트 프로세스는 이 요청을 적절한 클라이언트에 전달합니다.

- 클라이언트는 서버에 도구 호출 요청을 전송합니다.

- 서버는 요청된 작업을 수행하고 결과를 클라이언트에 반환합니다.

결과 처리(Result Processing)

- 클라이언트는 서버로부터 받은 결과를 호스트 프로세스에 전달합니다.

- 호스트 프로세스는 이 결과를 AI 모델에 제공합니다.

- AI 모델은 이 정보를 바탕으로 응답을 생성합니다.

MCP의 기술적 구현

MCP는 다양한 프로그래밍 언어로 구현될 수 있으며, 앤트로픽은 다음과 같은 SDK를 제공합니다:

- TypeScript SDK

- Python SDK

- Java SDK

- Kotlin SDK

이러한 SDK를 사용하여 개발자는 MCP 서버와 클라이언트를 쉽게 구현할 수 있습니다.

MCP Server 구현

Python에서는 fastmcp라는 라이브러리를 활용해 간단하게 MCP 서버를 구현할 수 있습니다.

https://github.com/jlowin/fastmcp

GitHub - jlowin/fastmcp: The fast, Pythonic way to build Model Context Protocol servers 🚀

The fast, Pythonic way to build Model Context Protocol servers 🚀 - GitHub - jlowin/fastmcp: The fast, Pythonic way to build Model Context Protocol servers 🚀

github.com

Python Fastmcp를 활용한 간단한 서버 구현 예제는 다음과 같습니다:

from typing import Any

import httpx

from mcp.server.fastmcp import FastMCP

# 서버 초기화

mcp = FastMCP("name-origin")

# API 기본 URL

base_url = "https://api.nationalize.io"

# 메서드 정의

@mcp.tool()

async def predict_origin(self, name: str) -> dict:

"""Nationalize API를 사용하여 주어진 이름의 출신 국가를 예측합니다

Args:

name (str): 출신 국가를 예측할 이름

Returns:

dict: 이름의 출신 국가

"""

async with httpx.AsyncClient() as client:

response = await client.get(f"{base_url}/?name={name}")

return response.json()

# 메서드 정의

@mcp.tool()

async def batch_predict(self, names: list[str]) -> dict:

"""여러 이름의 출신 국가를 한 번에 예측합니다

Args:

names (list[str]): 출신 국가를 예측할 이름 목록

Returns:

dict: 이름들의 출신 국가

"""

results = {}

for name in names:

results[name] = await self.predict_origin(name)

return results

if __name__ == "__main__":

print("이름 출신 국가 서버 시작 중...")

mcp.run(transport='stdio')

MCP Client 구현

from mcp import ClientSession, StdioServerParameters, types

from mcp.client.stdio import stdio_client

# Create server parameters for stdio connection

server_params = StdioServerParameters(

command="python", # Executable

args=["example_server.py"], # Optional command line arguments

env=None, # Optional environment variables

)

async def run():

async with stdio_client(server_params) as (read, write):

async with ClientSession(read, write) as session:

# Initialize the connection

await session.initialize()

# List available prompts

prompts = await session.list_prompts()

# Get a prompt

prompt = await session.get_prompt(

"example-prompt", arguments={"arg1": "value"}

)

# List available resources

resources = await session.list_resources()

# List available tools

tools = await session.list_tools()

# Read a resource

content, mime_type = await session.read_resource("file://some/path")

# Call a tool

result = await session.call_tool("tool-name", arguments={"arg1": "value"})

if __name__ == "__main__":

import asyncio

asyncio.run(run())

MCP와 기존 API의 차이점은 뭘까?

MCP는 기존의 API(Application Programming Interface) 및 함수 호출(Function Calling) 방식과 비교했을 때 여러 가지 중요한 차이점을 가지고 있습니다.

MCP 이전 방식들

커스텀 API 통합 (일회성 커넥터)

가장 일반적인 방법은 각 서비스마다 커스텀 코드를 작성하거나 SDK를 사용하는 방식입니다. 예를 들어, AI 에이전트가 Google Drive와 SQL 데이터베이스에 접근하려면, 각각 Google의 API와 데이터베이스 드라이버를 별도로 통합해야 하며, 각기 다른 인증 방식, 데이터 형식, 고유한 특징을 모두 고려해야 합니다. 매우 번거롭고 복잡한 작업입니다.

언어 모델 플러그인 (예: OpenAI Plugins 등)

2023년에는 모델이 외부 API를 안전하게 호출할 수 있도록 표준화된 플러그인 명세(OpenAPI 스키마 등)를 제공하는 방식도 등장했습니다. 대표적인 예로는 ChatGPT의 플러그인 시스템이 있습니다. 이 방식은 MCP처럼 도구 접근을 표준화한다는 점에서는 유사하지만, 폐쇄적이고 제한된 구조입니다. 각 플러그인은 개별적으로 구축 및 호스팅해야 하며, ChatGPT나 Bing Chat 같은 특정 플랫폼에서만 사용할 수 있습니다. 또한 대부분의 플러그인은 모델이 API를 호출해 정보를 받는 단방향 구조에 초점을 맞추고 있어, 지속적이고 상호작용적인 세션을 유지하지는 못합니다.

프레임워크 기반 도구 사용 (LangChain의 Tools, Agents 등)

LangChain과 같은 에이전트 오케스트레이션 프레임워크는 LLM에게 “도구”(함수)를 설명과 함께 제공하여, 모델이 상황에 따라 이를 호출하도록 하는 방식을 대중화했습니다. 예를 들어 search()나 calculate()와 같은 도구를 정의하고, 모델이 필요할 때 적절히 활용합니다.

이 방식은 매우 강력하지만, 각 도구는 여전히 내부적으로 커스텀 구현이 필요합니다. LangChain은 500개 이상의 도구를 일관된 인터페이스로 제공하고 있지만, 개발자는 여전히 각 도구를 자신의 요구에 맞게 연결하거나 수정해야 합니다.

MCP는 이러한 구조를 보완합니다. MCP는 도구를 구현하기 위한 표준화된 인터페이스를 제공하며, MCP 서버는 어떤 에이전트든 사용할 수 있는 도구의 라이브러리 역할을 합니다. 핵심적인 차이점은 표준화의 대상입니다. LangChain은 개발자 코드에서 도구를 통합하기 위한 표준을 제시하는 반면, MCP는 모델이 직접 런타임 중에 도구를 발견하고 사용하는 표준을 만듭니다. 즉, 특정 도구를 위해 에이전트 코드를 작성하지 않더라도, 모델은 MCP를 통해 해당 도구를 실시간으로 통합할 수 있습니다. 이러한 흐름은 점차 융합되고 있으며, 실제로 LangChain 팀은 MCP의 확산을 계기로 MCP 서버를 LangChain 도구처럼 활용할 수 있도록 어댑터를 제공하고 있습니다. 이로 인해 LangChain이나 다른 프레임워크 기반 에이전트도 MCP 도구를 자연스럽게 사용할 수 있게 되었으며, MCP 생태계의 이점을 함께 누릴 수 있게 되었습니다.

검색 기반 생성(RAG)과 벡터 데이터베이스

LLM에 외부 컨텍스트를 제공하는 가장 일반적인 방식 중 하나는 RAG(Retrieval-Augmented Generation)입니다. 이 방식은 지식 기반(문서, 임베딩 등)을 검색하여 관련 정보를 추출하고, 이를 프롬프트에 삽입하여 모델이 참고하도록 합니다. RAG는 모델의 지식 제한이나 메모리 부족 문제를 해결하는 데 효과적이지만, 주로 정적인 텍스트 조각을 제공하며, 모델이 직접 외부 시스템에 행동을 취하거나 동적 쿼리를 실행하는 것은 불가능합니다.

결과적으로, RAG는 수동적으로 컨텍스트를 제공하는 방식인 반면, MCP는 모델이 능동적으로 컨텍스트를 획득하거나 조작할 수 있도록 합니다. 특히 실시간 정보가 필요하거나, 데이터베이스 쿼리, 게시글 작성과 같은 동적인 작업이 필요한 상황에서는, MCP가 단순한 정보 조회를 넘어서 작업 실행까지 가능한 보다 범용적인 메커니즘으로 기능합니다.

기존 API 및 함수 호출의 한계

- 개별 통합의 필요성: 각 데이터 소스마다 별도의 API 연결을 설정하고 관리해야 했습니다. 예를 들어, AI가 구글 스프레드시트, 사내 문서 저장소, CRM 시스템에서 데이터를 가져와야 한다면, 이들 각각의 API를 별도로 설정하고 관리해야 했습니다.

- 단방향 통신: 대부분의 API 호출은 단방향 통신 방식으로, AI가 데이터를 요청하면 서버가 한 번 응답하고 끝나는 방식이었습니다. 지속적인 상호작용이 어려웠습니다.

- 개발자 중심 설계: API 통합은 주로 개발자를 위해 설계되어 있어, 기술적 지식이 없는 사용자가 활용하기 어려웠습니다.

- 확장성 제한: 여러 데이터 소스를 통합할수록 복잡성이 기하급수적으로 증가하여 확장성에 제한이 있었습니다.

- 컨텍스트 유지의 어려움: 여러 시스템 간에 컨텍스트를 유지하기 어려워, AI가 다양한 도구와 데이터 소스를 오가며 작업할 때 일관성을 유지하기 어려웠습니다.

MCP의 차별화된 특징

MCP는 이러한 한계를 극복하기 위해 설계되었으며, 다음과 같은 차별화된 특징을 가지고 있습니다:

- 표준화된 프로토콜: MCP는 모든 데이터 소스와 도구에 대한 단일 표준 프로토콜을 제공합니다. 개발자는 각 데이터 소스마다 별도의 커넥터를 유지할 필요 없이 하나의 프로토콜을 통해 모든 연결을 관리할 수 있습니다.

- 양방향 통신: MCP는 AI 모델과 데이터 소스 간의 양방향 통신을 지원합니다. AI와 데이터 소스가 지속적으로 연결된 상태에서 서로 정보를 주고받을 수 있어, 더 복잡하고 상호작용적인 작업이 가능합니다.

- 사용자 친화적 설계: MCP는 개발자뿐만 아니라 기술적 지식이 없는 사용자도 쉽게 활용할 수 있도록 설계되었습니다. 자연어로 AI의 행동을 조작할 수 있는 가능성이 커졌습니다.

- 확장성 향상: 표준화된 프로토콜을 통해 여러 데이터 소스와 도구를 쉽게 통합할 수 있어, 확장성이 크게 향상되었습니다.

- 컨텍스트 유지: MCP는 여러 시스템 간에 컨텍스트를 유지할 수 있어, AI가 다양한 도구와 데이터 소스를 오가며 작업할 때도 일관성을 유지할 수 있습니다.

- 오픈소스 생태계: MCP는 오픈소스로 공개되어 있어, 커뮤니티의 기여와 혁신을 통해 지속적으로 발전할 수 있습니다.

실제 사용 시나리오에서의 차이점

실제 사용 시나리오에서 MCP와 기존 API의 차이점을 살펴보겠습니다:

시나리오 1: 데이터 분석

기존 API 방식:

- AI에게 데이터 분석을 요청합니다.

- AI는 특정 데이터베이스에 접근하기 위한 API 호출을 생성합니다.

- 개발자가 이 API 호출을 구현하고 실행합니다.

- 데이터가 반환되면 AI는 이를 분석합니다.

- 추가 데이터가 필요한 경우 새로운 API 호출을 생성하고 과정을 반복합니다.

MCP 방식:

- AI에게 데이터 분석을 요청합니다.

- AI는 MCP를 통해 데이터베이스에 직접 연결됩니다.

- AI는 필요한 데이터를 실시간으로 쿼리하고 분석합니다.

- 추가 데이터가 필요한 경우 같은 연결을 통해 즉시 요청할 수 있습니다.

- 분석 결과를 바탕으로 데이터베이스에 업데이트를 적용할 수도 있습니다.

시나리오 2: 문서 작성

기존 API 방식:

- AI에게 회사 정책에 기반한 문서 작성을 요청합니다.

- AI는 정책 문서에 접근하기 위한 API 호출을 생성합니다.

- 개발자가 이 API 호출을 구현하고 실행합니다.

- 정책 문서가 반환되면 AI는 이를 기반으로 문서를 작성합니다.

- 작성된 문서는 별도의 API 호출을 통해 저장해야 합니다.

MCP 방식:

- AI에게 회사 정책에 기반한 문서 작성을 요청합니다.

- AI는 MCP를 통해 정책 문서 저장소에 직접 연결됩니다.

- AI는 필요한 정책 문서를 실시간으로 검색하고 참조합니다.

- 문서 작성 중 추가 정보가 필요한 경우 같은 연결을 통해 즉시 접근할 수 있습니다.

- 작성된 문서는 MCP를 통해 직접 저장소에 저장할 수 있습니다.

MCP가 최근 화제가 되는 이유

접근성과 사용 편의성 향상

MCP가 주목받는 첫 번째 이유는 개발자가 아닌 일반 사용자도 상대적으로 쉽게 활용할 수 있다는 점입니다. 기존 방식에서는 AI가 특정 데이터를 가져오려면 개발자가 직접 API를 설정해야 했지만, MCP를 활용하면 이런 과정이 훨씬 단순해지고 자연어로도 AI의 행동을 조작할 수 있는 가능성이 커집니다.

Claude Desktop 앱에서 MCP 서버를 쉽게 설치하고 연결할 수 있게 되면서, 기술적 지식이 없는 사용자도 AI가 로컬 파일 시스템, 데이터베이스, 웹 서비스 등에 접근할 수 있도록 설정할 수 있게 되었습니다. 이는 AI의 활용 범위를 크게 확장시키는 요인이 되고 있습니다.

오픈소스 생태계의 성장

MCP가 오픈소스로 공개되었다는 점은 혁신을 가속화하는 중요한 요인입니다. 누구나 자유롭게 MCP를 실험하고 개선할 수 있기 때문에 다양한 응용 사례가 빠르게 등장하고 있습니다. GitHub에서 MCP 관련 저장소는 이미 10,800명 이상의 팔로워를 보유하고 있으며, 다양한 언어(TypeScript, Python, Java, Kotlin 등)로 SDK가 제공되고 있습니다.

오픈소스 커뮤니티의 활발한 참여로 인해 다양한 데이터 소스와 도구에 대한 MCP 서버가 개발되고 있으며, 이는 MCP 생태계의 빠른 성장을 촉진하고 있습니다. 앤트로픽은 Google Drive, Slack, GitHub, Git, Postgres, Puppeteer 등 인기 있는 엔터프라이즈 시스템을 위한 사전 구축된 MCP 서버를 공유하고 있습니다.

다른 LLM과의 호환성

MCP는 앤트로픽의 Claude에만 국한되지 않고 다른 대규모 언어 모델(LLM)과도 호환된다는 점이 주목받고 있습니다. LinkedIn 포스트에 따르면, Amazon Bedrock과 같은 다른 LLM 서비스에서도 MCP를 활용할 수 있다는 것이 확인되었습니다. 이는 MCP가 특정 모델에 종속되지 않고 AI 생태계 전반에 영향을 미칠 수 있는 범용 표준으로 자리잡을 가능성을 보여줍니다.

다양한 LLM과의 호환성은 개발자들이 여러 AI 모델을 활용하는 애플리케이션을 더 쉽게 구축할 수 있게 해주며, 이는 MCP의 채택률을 높이는 요인이 되고 있습니다.

AI 에이전트 패러다임의 부상

최근 AI 분야에서는 단순한 질의응답을 넘어 복잡한 작업을 자율적으로 수행할 수 있는 AI 에이전트에 대한 관심이 높아지고 있습니다. MCP는 이러한 AI 에이전트 패러다임과 완벽하게 맞아떨어지는 기술입니다.

MCP를 통해 AI 에이전트는 다양한 데이터 소스와 도구에 접근하여 복잡한 작업을 수행할 수 있게 됩니다. 예를 들어, 코딩 작업을 수행하는 AI 에이전트는 MCP를 통해 코드 저장소, 개발 환경, 문서 등에 접근하여 더 정확하고 유용한 코드를 생성할 수 있습니다.

실제로 Zed, Replit, Codeium, Sourcegraph와 같은 개발 도구 회사들은 MCP를 활용하여 AI 에이전트가 코딩 작업 주변의 컨텍스트를 더 잘 이해하고, 더 정교하고 기능적인 코드를 생성할 수 있도록 하고 있습니다.

실질적인 활용 사례의 증가

처음 MCP가 공개되었을 때는 또 하나의 기술적 시도 정도로 여겨졌지만, 최근 들어 AI의 실질적인 활용 방식이 변화하면서 점점 더 많은 사람들이 이 기술을 주목하고 있습니다. 특히 X(구 트위터)와 같은 SNS 및 AI 커뮤니티에서는 MCP를 활용한 자동화 사례가 늘어나고 있으며, AI 에이전트가 실질적인 업무를 처리하는 모습도 점점 보이고 있습니다.

Block(구 Square)과 Apollo와 같은 기업들은 이미 MCP를 자사 시스템에 통합하고 있으며, 이는 MCP가 단순한 실험적 기술이 아닌 실제 비즈니스 환경에서 가치를 창출할 수 있는 기술임을 보여줍니다.

멀티턴 상호작용의 중요성 증가

AI와의 상호작용 방식이 단순한 일회성 질의응답에서 여러 차례의 대화를 통한 복잡한 작업 수행으로 변화하면서, 멀티턴(Multi-turn) 상호작용의 중요성이 커지고 있습니다. MCP는 이러한 멀티턴 상호작용을 효과적으로 지원하는 기술입니다.

MCP를 통해 AI는 사용자와의 대화 중에 필요한 정보를 실시간으로 가져오고, 이를 바탕으로 더 정확하고 유용한 응답을 제공할 수 있습니다. 또한, 여러 차례의 대화를 통해 복잡한 작업을 단계적으로 수행할 수 있어, AI의 활용 범위가 크게 확장됩니다.

결론

Model Context Protocol(MCP)은 앤트로픽이 2024년 11월에 오픈소스로 공개한 혁신적인 기술로, AI 모델과 외부 데이터 소스 및 도구 간의 원활한 연결을 가능하게 합니다. MCP는 단순한 기술적 혁신을 넘어, AI가 실제 세계의 데이터와 시스템과 상호작용하는 방식에 근본적인 변화를 가져오고 있습니다.

MCP의 주요 특징인 개방형 표준, 양방향 연결, 범용성과 표준화, 보안 및 신뢰성은 기존 API 및 함수 호출 방식의 한계를 극복하고, AI 모델의 활용 범위를 크게 확장시키고 있습니다. 특히 클라이언트-서버 아키텍처를 기반으로 한 MCP의 기술적 구조는 확장성, 모듈성, 보안성을 고려하여 설계되었으며, 이를 통해 AI 모델과 외부 데이터 소스 간의 원활한 통합이 가능해졌습니다.

MCP가 최근 화제가 되는 이유는 접근성과 사용 편의성 향상, 오픈소스 생태계의 성장, 다른 LLM과의 호환성, AI 에이전트 패러다임의 부상, 실질적인 활용 사례의 증가, 멀티턴 상호작용의 중요성 증가 등 다양한 요인이 있습니다. 이러한 요인들로 인해 MCP는 AI 커뮤니티에서 큰 관심을 받고 있으며, 실제 비즈니스 환경에서도 활용되고 있습니다.

현재 MCP는 소프트웨어 개발 및 코딩 지원, 기업 데이터 통합 및 분석, 문서 관리 및 지식 접근, 로컬 파일 시스템 접근, 데이터베이스 접근 및 쿼리 등 다양한 분야에서 활용되고 있습니다. 미래에는 AI 에이전트의 발전, 생태계의 확장, 산업별 특화 솔루션, 개인화된 AI 비서의 발전, 보안 및 개인정보 보호 강화, 멀티모달 통합 등을 통해 더 큰 영향을 미칠 것으로 전망됩니다.

물론 MCP는 아직 초기 단계이기 때문에 과장된 기대라는 시각도 있지만, 실질적인 사례가 쌓이고 있다는 점에서 단순한 유행보다는 AI 기술의 다음 단계를 여는 중요한 전환점이 될 가능성이 높아 보입니다. 앞으로 MCP가 AI 생태계에 어떤 변화를 가져올지 지속적으로 주목할 필요가 있습니다.

참고 자료

- https://www.anthropic.com/news/model-context-protocol

- https://modelcontextprotocol.io/introduction

- https://wandb.ai/onlineinference/mcp/reports/The-Model-Context-Protocol-MCP-by-Anthropic-Origins-functionality-and-impact--VmlldzoxMTY5NDI4MQ

- https://github.com/modelcontextprotocol

- https://blog.stackademic.com/everything-you-need-to-know-about-the-model-context-protocol-mcp-from-anthropic-84acdb3c1a2f

- https://huggingface.co/blog/Kseniase/mcp#so-what-is-mcp-and-how-does-it-work

- https://contents.premium.naver.com/banya/banyacompany/contents/250312102008773xh

'AI > 어플리케이션 개발' 카테고리의 다른 글

| Cursor에서 MCP (Model Context Protocol) 사용하기 (1) | 2025.04.03 |

|---|---|

| MCP(Model Context Protocol)이 뭐길래? 실습편 (3) | 2025.03.21 |

| LangChain을 활용한 Tool Calling # 4 (3) | 2024.11.29 |

| LangChain을 활용한 Tool Calling # 3 (0) | 2024.11.29 |

| LangChain을 활용한 Tool Calling # 2 (3) | 2024.11.29 |