최근 자연어 처리(NLP) 분야에서 대형 언어 모델(Large Language Models, 이하 LLM)의 성과가 눈부십니다. OpenAI의 GPT-4와 Google의 PaLM 2 같은 최신 LLM은 다양한 NLP 작업에서 뛰어난 제로샷(zero-shot) 성능을 입증하며 주목받고 있습니다. 이러한 성과는 단순한 질의응답을 넘어 텍스트 순위 매기기(text ranking)라는 새로운 응용 분야로 확장되고 있습니다.

이전 포스트에서 LLM을 사용하여 도큐먼트의 ranking을 매기는 방법에 대해서 다루었으니, 관심 있으신 분들은 참고하시면 좋을 것 같습니다.

Retrieval을 위한 zero-shot LLM Ranker

앞서서최근 자연어 처리(NLP) 분야에서 대형 언어 모델(Large Language Models, 이하 LLM)의 성과가 눈부십니다. OpenAI의 GPT-4와 Google의 PaLM 2 같은 최신 LLM은 다양한 NLP 작업에서 뛰어난 제로샷(zero-shot) 성

dytis.tistory.com

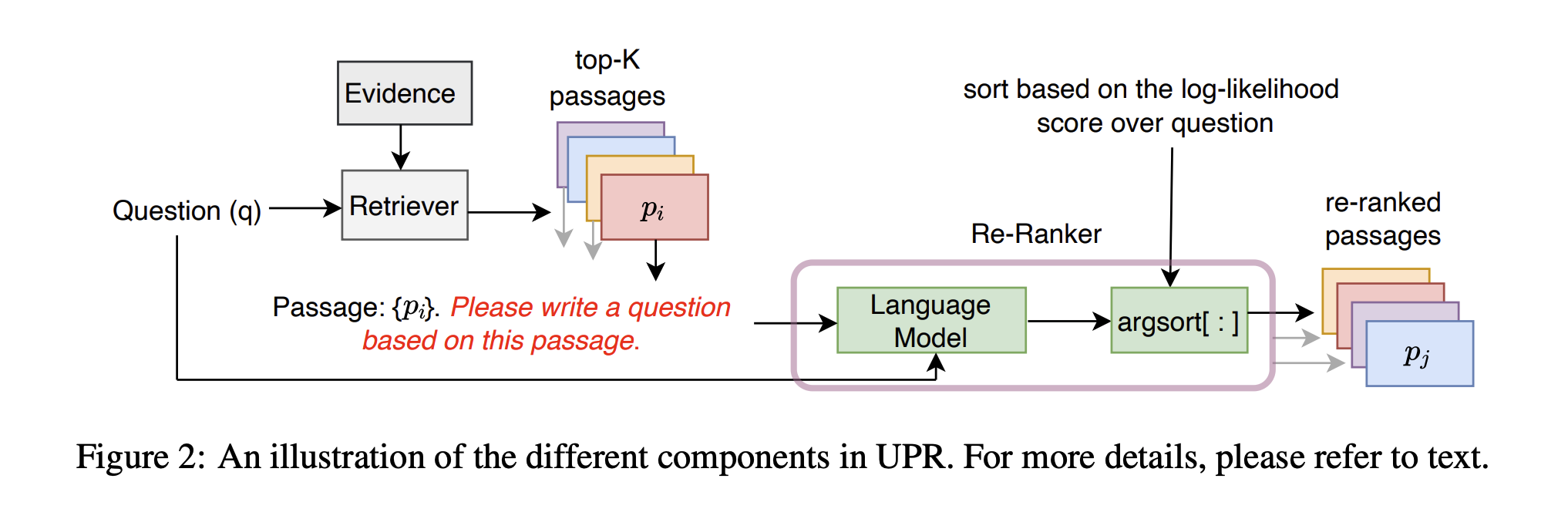

이번 포스트에서는 검색 시스템의 초기 후보 패시지에서 최적의 순위를 매기는 Re-ranking 기술 중 Zero-Shot Question Generation을 활용한 새로운 패시지 재정렬 방법론인 UPR(Unsupervised Passage Re-ranking)을 소개합니다. (Sachan et al. (2022))

방법론

Passage 검색

먼저 기존의 검색 모델(예: BM25, DPR)을 사용하여 주어진 질문에 대한 상위 K개의 관련 패시지를 검색합니다.

이를 통해 초기 후보 패시지 집합 Z = { z_1, z_2, ..., z_K }가 생성됩니다.

Passage Re-Ranking

이 후, 각 패시지 z_i 에 대해 질문 가 생성될 확률 p(q|z_i)를 계산합니다.

확률 계산은 PLM을 사용하며, 구체적으로 아래 식을 사용합니다

계산된 log p(q | z_i) 를 사용하여 패시지 집합 Z를 다시 정렬합니다.

이를 통해 질문에 가장 적합한 패시지가 상위에 위치하도록 합니다.

성능

실험 방법 및 설정

연구에서는 UPR(Unsupervised Passage Re-ranking)의 성능을 검증하기 위해 다양한 검색 모델과 Re-ranker 모델을 조합해 실험을 진행했습니다. 실험은 먼저 기존 검색 모델을 활용해 상위 1000개의 패시지를 검색한 뒤, 이를 UPR을 통해 재정렬하는 방식으로 이루어졌습니다.

검색 모델로는 BM25, Contriever, DPR, 그리고 MSS-DPR이 사용되었습니다. BM25는 키워드 기반 검색의 대표적인 방식으로, 간단하면서도 높은 정확도를 자랑합니다. Contriever는 대조 학습(Contrastive Learning) 기반으로 밀집 표현을 사용하는 모델이며, 지도 학습 기반의 DPR 및 MSS-DPR은 더욱 정밀한 검색 결과를 제공합니다.

재정렬(Re-ranking)을 위해 사용된 모델로는 T5 시리즈(T5 및 T5-lm-adapt), T0 모델(Instruction-tuning 기반), 그리고 GPT-neo가 있습니다. 특히 T0 모델은 다양한 작업에 대해 Instruction-tuning을 수행한 PLM으로, 질문 생성과 같은 작업에서 강력한 성능을 발휘합니다.

모델 성능 평가는 Top-K Accuracy를 기준으로 이루어졌습니다. 이는 상위 K개의 검색된 패시지 중 정답을 포함한 패시지의 비율을 측정하여 모델의 정확도를 평가하는 지표입니다.

실험 결과

UPR은 기존 검색 모델 대비 성능을 크게 향상시켰으며, 특히 Top-20 정확도에서 놀라운 개선을 보여주었습니다. BM25의 경우, Top-20 정확도가 6%에서 18%까지 개선되었고, Contriever는 기존 지도 학습 기반 모델인 DPR보다도 더 높은 성능을 기록했습니다. 지도 학습 기반 모델인 MSS-DPR 역시 UPR을 적용한 결과 추가적인 성능 향상을 보였습니다.

UPR의 또 다른 강점은 다양한 데이터셋에서의 일반화 가능성입니다. Entity Questions와 BEIR Benchmark 같은 도메인 이질성이 큰 데이터셋에서도 높은 성능을 보여주었는데요. 예를 들어, Entity Questions 데이터셋에서 BM25의 Top-20 정확도는 71.2%였으나, UPR을 적용한 후에는 79.3%로 상승했습니다. BEIR Benchmark에서도 Contriever의 nDCG@10이 36.0에서 44.6으로 개선되는 성과를 보였습니다.

PLM의 성능 비교 실험에서는 T0 모델(특히 3B와 11B 크기)이 가장 높은 성능을 기록했습니다. Natural Questions(NQ) 데이터셋에서 T0-3B와 T0-11B는 모두 Top-20 정확도에서 79.1%를 기록했으며, Instruction-tuning을 통해 학습된 T0 모델은 다른 PLM보다 질문 생성 확률을 더욱 정확하게 평가했습니다.

Zero-Shot 방식의 UPR은 지도 학습 기반 Re-ranker인 monoT5와도 비교해볼 만한 성능을 보여줬습니다. 지도 학습 모델 monoT5-3B가 NQ 데이터셋에서 Top-20 정확도 78.7%를 기록한 반면, UPR(T0-3B)은 76.8%로 매우 근접한 성능을 달성했습니다. 이를 통해 UPR이 대규모 데이터 학습 없이도 경쟁력 있는 결과를 낼 수 있음을 확인할 수 있었습니다.

결과 분석 및 결론

이번 연구를 통해 UPR은 기존 검색 모델의 한계를 극복하고, 상위 패시지의 정확도를 크게 향상시킬 수 있음을 입증했습니다. 특히 특정 데이터셋이나 도메인에 한정되지 않고 다양한 환경에서 일관된 성능 개선을 보여줬다는 점은 주목할 만합니다. 또한 Zero-Shot 방식으로 별도의 추가 학습이나 데이터 레이블링 없이 높은 성능을 달성할 수 있다는 점에서 효율성도 뛰어납니다.

'AI > 검색 시스템' 카테고리의 다른 글

| Retrieval 시스템을 위한 MTEB 벤치마크 (3) | 2025.01.03 |

|---|---|

| Retrieval 시스템을 위한 BEIR 벤치마크 (2) | 2025.01.03 |

| Retrieval을 위한 zero-shot LLM Ranker (5) | 2024.12.27 |

| Retrieval 시스템 평가 매트릭 (2) | 2024.12.19 |

| Retrieval 시스템이란? (2) | 2024.12.09 |